南京师范大学语言大数据与计算人文研究中心于2024年1月16日晚成功举办“数字人文系列讲坛”第二场讲座。此次讲座邀请的演讲嘉宾是南京农业大学的王东波教授,以“荀子古籍大模型的构建及应用研究”为主题,为我们呈现了一场精彩的学术盛宴。

讲座由南京师范大学李斌老师主持,介绍了王东波教授的相关学术成就以及本次讲座的主要内容。随后,王教授围绕着“研究背景、古籍大模型构建方案与技术、古籍大模型构建结果、未来研究计划”四个方面,介绍了“荀子”古籍大模型这一重大研究成果,并对其开发过程进行了深入而详细的阐释。

一、研究背景

王东波教授首先指出,目前以ChatGPT为代表的大模型已经点燃了AI产业革命的火花,产业界和学术界掀起了大模型开发与应用的浪潮。同时,中共中央办公厅印发了《关于推进新时代古籍工作的意见》,指出推进古籍数字化、做好古籍普及传播将是未来的重点方向。时代的进步,社会的发展启示我们需要做时代背景下有价值、有意义的事情。古籍内容作为一个封闭的集合,与大语言模型(LLM)有着天然的结合性,因此古籍智能处理将是LLM落地的重要场景所在,在大语言模型的支持下,古籍的信息处理也将形成新的范式。随后,王教授介绍 了“荀子”大模型的处理方案:在开源基座上以继续预训练的方法建构、面向用户的古籍对话大模型和专用任务对话大模型。

二、古籍大模型构建方案与技术

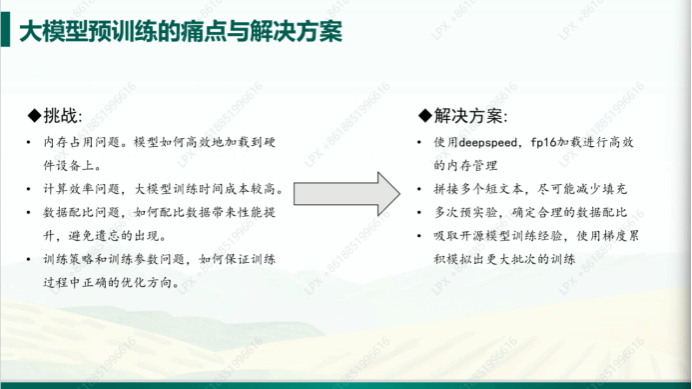

王东波教授指出,荀子是我国历史中严格意义上的第一位语言学的探究者,也正是因此该一系列模型将统一命名为“荀子”。接下来,王教授对大模型预训练步骤、数据量、scaling laws等方面进行了阐述,并通过具体的例子对继续预训练方法以及预训练过程中存在的挑战与解决方案进行了解释和分析。他详细地介绍了“荀子”模型预训练数据集的构造与配比,并讲解了一些训练技巧,对于后续对话模型的训练过程与训练数据,王教授同样进行了阐释。

三、古籍大模型构建效果

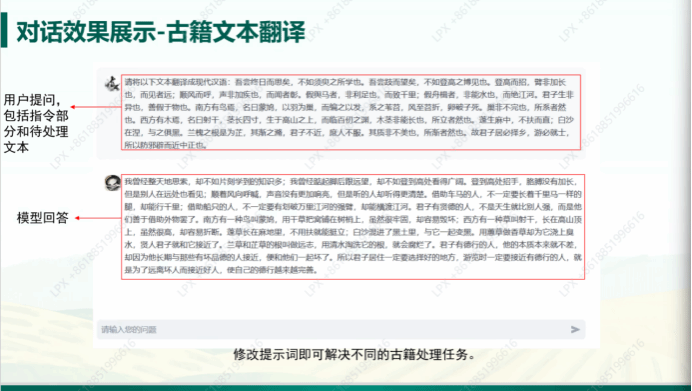

王东波教授展示了模型的预训练结果、微调任务以及微调数据样例。对比展现了在不同基座模型上对文本翻译、文本匹配、文本分类、分词和命名实体识别五种下游任务的性能表现,评估了模型的整体性能。王教授对该实验结果进行了总结,指出继续预训练可以增强大语言模型在处理领域数据上的能力,而垂直领域的大语言模型的训练将是未来的重点和热点。随后,王教授以古籍文本翻译为例,展示了模型对话效果,用户可以通过修改提问指令中的提示词,便可解决不同的古籍处理任务。今后,通过进一步设计提示词(prompt),能够引导模型产生特定的输出以完成更细的需求。“荀子”系列古籍模型作为开源的、共享的公益性研究成果,用户可以自行下载并部署使用。

下载地址:

//github.com/Xunzi-LLM-of-Chinese-classics/XunziALLM

四、未来研究计划

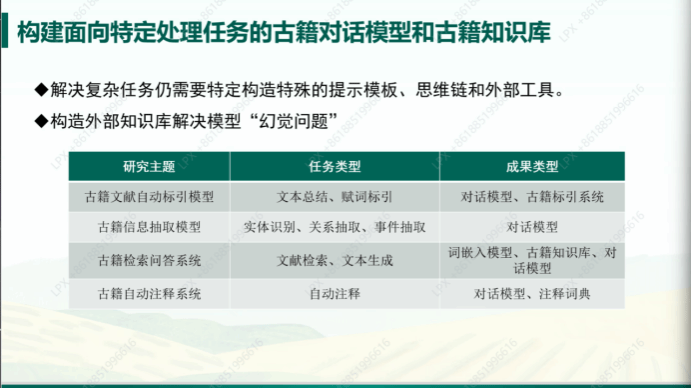

王东波教授进一步明确了未来的研究计划。首先,是提供更多参数更大的基座模型。他展示了目前已经设计完成的模型及其训练状态,并指出进行该研究的初衷是希望做好、做大、做强古籍智能化,因此希望大家能够真正使用模型,在使用中反馈问题,以便改进。他同样说明了在生成回答的过程中会出现的一些问题,而解决方案则是构建面向特定处理任务的古籍对话模型和古籍知识库。通过构造特殊的提示模板、思维链和外部工具,从而解决更为复杂的任务;通过构造外部知识库,从而解决模型的“幻觉问题”等等。王教授以不同的研究任务为例,具体说明了在未来能够进一步深化的研究方向。

结语

最后,王教授感谢了众多合作者。他指出,目前大语言模型的发展趋势是领域化的,“荀子”古籍大模型作为多方助力下形成的研究成果,是大模型在古籍智能处理领域的第一步,在未来也将不断改进,加强对不同应用场景的覆盖,他强调“荀子”系列模型将始终保持共享。随后,刘畅同学进行了“荀子”模型的实际操作演示,他详细地说明了下载和部署的相关操作,展示了模型在翻译、实体识别、文本摘要、古文标点、词法分析、阅读理解和诗歌生成等具体任务中的强大效用。

大语言模型将会给古籍的处理任务带来根深蒂固的改变,但也存在一些问题。在答疑环节,赵志枭同学对不同使用者所反馈的问题给予了详细的解答,并由此说明了未来的研究重点与改进方向。

在本次讲座的最后,李斌老师进行了总结。大模型给古汉语智能处理带来了质的飞跃,而怎么利用好大模型,将成为自然语言处理和计算语言学中重要的话题。他希望不同研究方向的使用者能够提供建议,这些多角度的建议将对大模型落地有着重要的帮助,期待大模型越做越好,不断提供更多更好的资源。